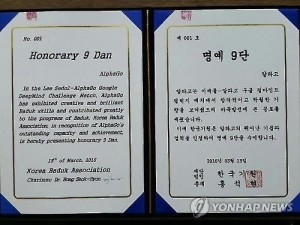

Компьютеры уже превосходят человека в большинстве самых разнообразных игр, возьмем мы шахматы, отелло, эрудит, нарды или покер. Однако игра Го до создания AlphaGo оставалась недостижимой вершиной для компьютерных программ. Пожалуй, это последняя и единственная игра, в которой сеть доминирует над «железом». Ведь в мозгу человека функционирует нейронная сеть, а не процессор.

Изобретенная более 2500 лет назад в Китае, игра Го была любимым занятием императоров и полководцев, интеллектуалов и вундеркиндов. Подобно шахматам, это игра с полной информацией, где ничего не скрыто от другого игрока как в картах, и нет элемента случайности, как в играх с кубиком. И, как и шахматы, Го — это война двух сил.

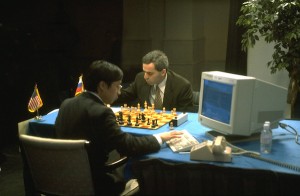

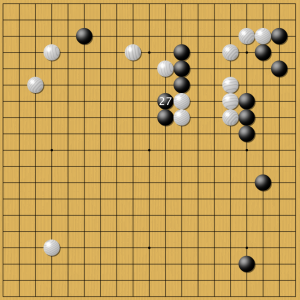

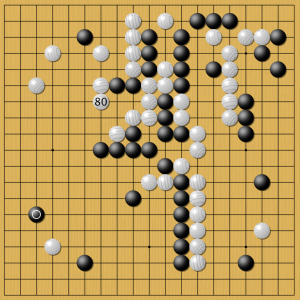

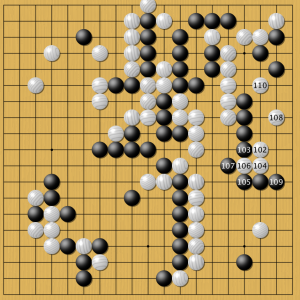

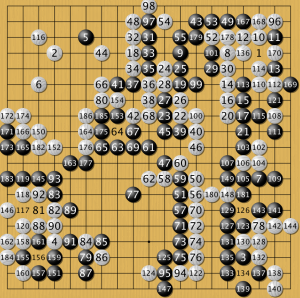

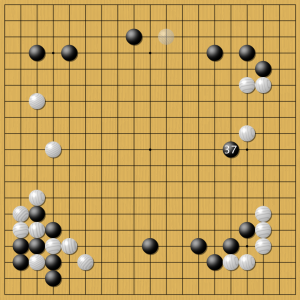

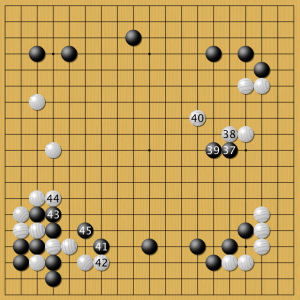

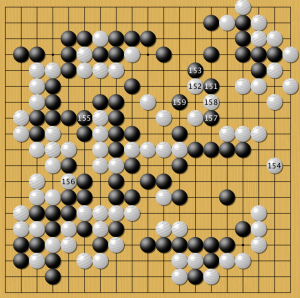

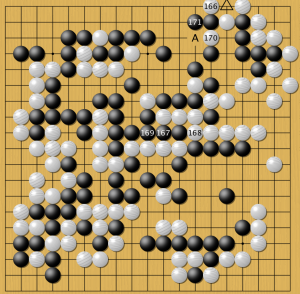

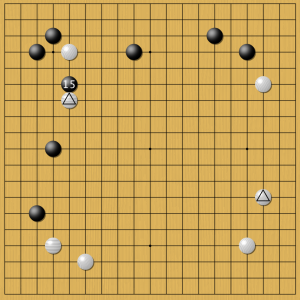

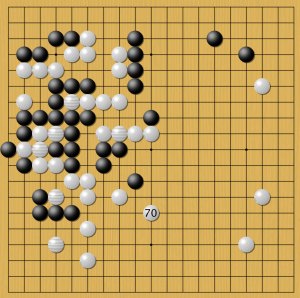

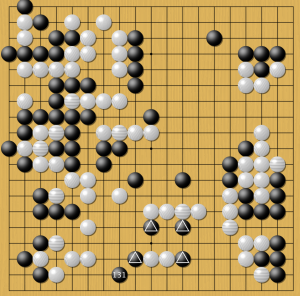

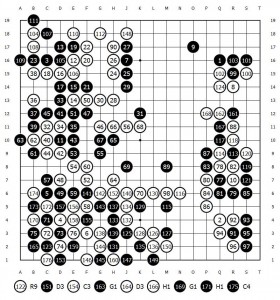

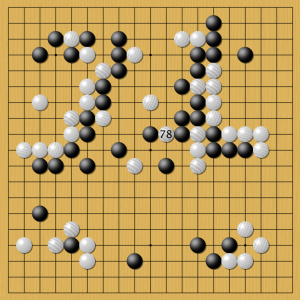

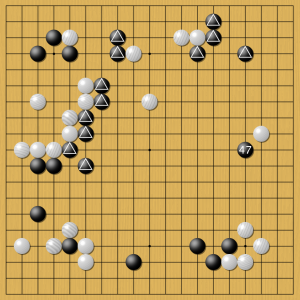

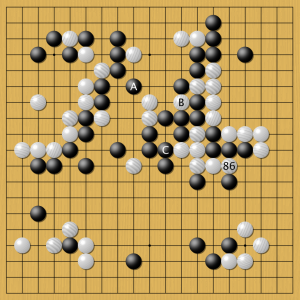

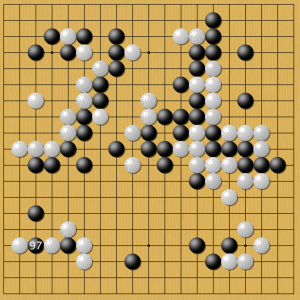

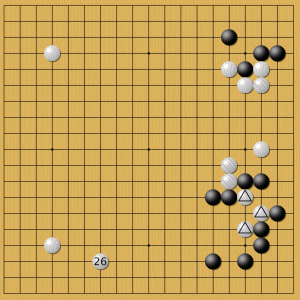

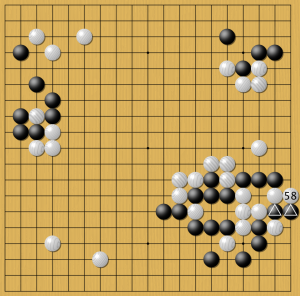

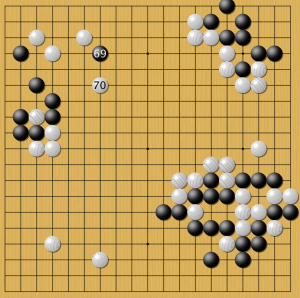

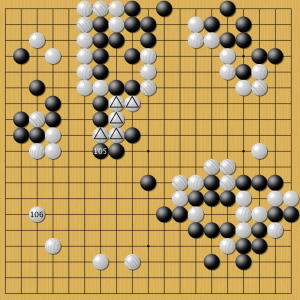

Игра начинается с пустой доски, на которую игроки по очереди ставят черные и белые камни, деля и огораживая территорию, стремясь при этом избежать захвата своих камней противником. Может показаться, что Го проще, чем шахматы, но это не так. Когда Deep Blue уже побеждал Каспарова, лучшие программы Го не могли обыграть любителя среднего уровня. Несмотря на огромный рост мощности современных компьютеров, создание программы Го, играющей на уровне мастера, оставалось одной из самых больших нерешенных загадок искусственного интеллекта.

На западе Го с давних пор является любимой игрой математиков, физиков и программистов. Еще Лейбниц в далеком 18 веке писал об удивившей его своей сложностью китайской игре Го. Эйнштейн играл в Го во время своего пребывания в Принстоне, также как и математик Джон Нэш, получивший впоследствии нобелевскую премию за исследования по теории игр.

Один из основателей программирования Алан Тьюринг серьезно увлекался игрой Го. Работая над расшифровкой немецких шифров во время Второй мировой войны, он познакомил с Го криптографа Ирвинга Гуда. Гуд получил известность благодаря своей концепции технологической сингулярности, согласно которой рано или поздно машины станут умнее людей. В 1965 время его статья «Тайна Го» в журнале New Scientist дала огромный толчок к росту популярности Го в Европе, подобно эффекту публикаций В. Асташкина и Г. Нилова в советском журнале «Наука и жизнь».