Фактор машины

Date - 14.03.2016 / Author - admin / Category - AlphaGo, Uncategorized, Без рубрики, интеллект, НовостиВо вчерашнем матче между умной машиной и человеком мы увидели новую интересную вещь. Она знакома по игре с компьютерными ботами в Го. Но боты принято в расчеты вообще не брать, ругаться с ними в чате и всячески их унижать, благо они не отвечают. Тут все-таки было три блестящих победы над чемпионом. В четвертой игре мы увидели, как себя ведет прототип искусственного интеллекта в нестандартной, непонятной, или какой-то иной ситуации, выходящей за рамки заложенных в него представлений о комфорте. Я назвал его поведение «машинным фактором» наподобие человеческого фактора.

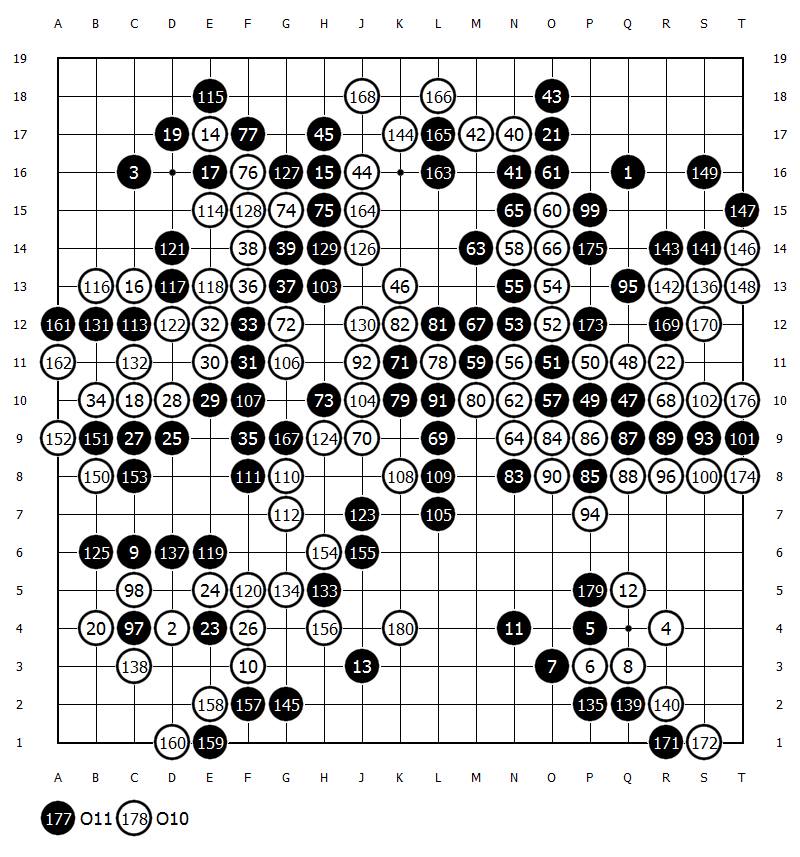

Оно похоже на поведение человека (пусть даже эксперта в чем-то), которого вынули из зоны комфорта. Обычно он начинает дурить, метаться и совершать глупости. Мы привыкли думать, что компьютер силен в расчетах и поэтому его нельзя пересчитать, но слаб в стратегии и творчестве. Создатели AlphaGo нашли свой способ обойти эту слабость машины, сделав ее практически интуитивной. Но в результате она получила этот баг «человечности». Оказалось, что у нее есть свои страхи. Например, она старается избегать сложной Ко-борьбы. В том числе этим объясняют ее действия в правой части доски (постановки 87-101), когда она упорно тянула мертвые камни, разрушая свое влияние вокруг. AlphaGo можно обмануть и пересчитать, как и человека. И это значит, что против нее начинают работать наши эволюционные преимущества, которые я считал главным минусом борьбы между Ли Седолем и AlphaGo. Впрочем, он и сам об этом сказал после первой игры, признавшись, что шокирован психологическим давлением бесконтактной борьбы с AlphaGo.

To make long story short, я выскажу как аксиому мысль, что человек состоит из трех центров — двигательного, эмоционального и интеллектуального, в то время как машина (в Го на данный момент так) состоит только из интеллектуального центра.

Человек ограничен тремя лимитами, а машина только одним. Человек не только может сглупить в расчетах, он устает физически и от этого начинает хуже думать. Добавим к этому эмоциональную неустойчивость. Ли Седолю катастрофически не хватало эмоциональности машины, которая бы его боялась. Он привык к этому. Да и энергетика у него, я думаю, чудовищной силы. Он раздавит ею любого оппонента. Но в матче ему приходилось опираться только на качество своего ума. И машина очевидно превосходила его в этом. Однако в предельных ситуациях человек может опираться на три своих центра, превосходя машинный интеллект.

Я полагаю, что машина оптимизирует и почти всегда исходит из рациональных посылок. У нее не может возникнуть желания «навалять этому чемпиону люлей» ради удовольствия. Я не думаю, что это легко алгоритмизировать. И она не будет играть в ситуации, где не видит шанса на победу. А Ли Седоль будет. Потому что он человек и он хочет победить, даже если борьба по мнению машины уже бесполезна. Это чистая эмоция, то, что можно назвать иррациональным поведением.

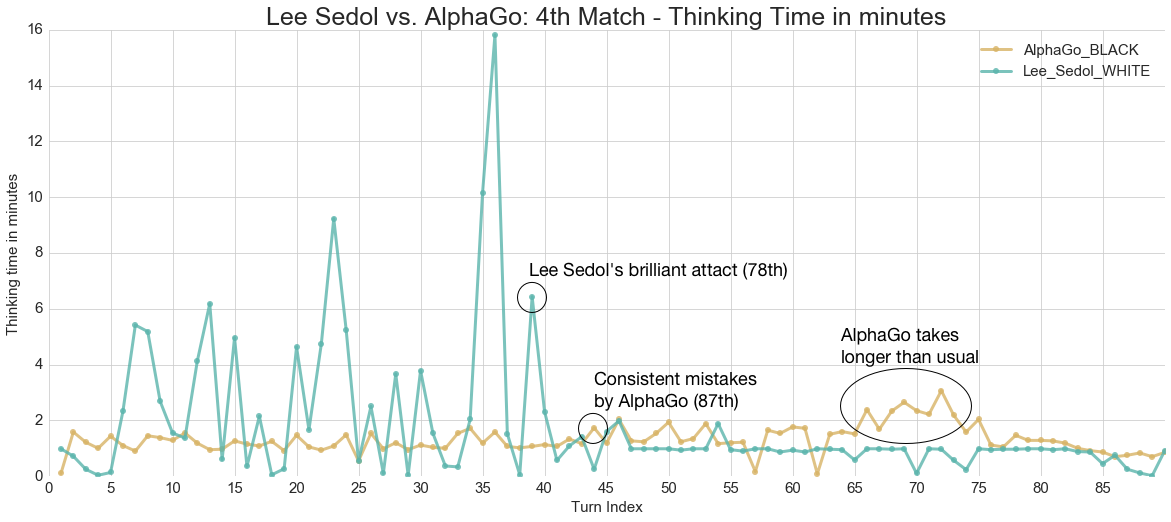

Что произошло в 4-й игре. Ли Седоль как и в предыдущих партиях стратегически проиграл машине, которая умеет очень тонко оценивать баланс, выбирая меньшее, но приближающее к победе. Но она не считает все варианты. И это важно. То есть как и для человека, для программы Го — это огромное черное пятно, где у AlphaGo более точные представления о том, что выгодно, а что нет. И знаменитая постановка 78 случайно не оказалась в числе рассматриваемых вариантов машиной, так как она строит свою выборку случайным образом. Как известно, уже найдено опровержение этого решения. Оно сработало потому, что машина ошиблась в расчетах.

Любопытно узнать, что произошло с оценкой позиции после появления камня 78. Как я понял из твитов Хассабиса, программа «поняла» что данный камень разрушает ее территорию только через несколько постановок. И это означает, что у нее произошло революционное изменение оценки общего баланса. Примерно такой же мощности, как в сознании ребенка, который пришел в магазин за вкусняшкой, долго выбирал ее и приценивался, наконец выбрал, отстоял в кассе очередь и оказалось, что он забыл деньги в другой куртке. Ребенок в такой ситуации впадает во фрустрацию. Более простые схемы фрустрационного поведения или детских капризов вы можете наблюдать каждый день, когда ребенок не получает то, на что он рассчитывал. Как он себя ведет? Хаотично и предсказуемо нерационально. Кстати, похожим образом новички и дети играют в Го, пытаясь убить камни за несколько постановок подряд. Хотя очевидно, что такого шанса у них не будет.

По моей версии с AlphaGo случилась похожая штука. И она начала чудить. Так как ее оптимизационный механизм не давал ей хорошего решения проблемы. Она не могла собраться с мыслями, посмотреть по сторонам, сходить покурить или просто разозлиться и решить: «надеру задницу этому засранцу». Программа действует рационально, или же моделирует человеческую глупость, пытаясь найти что-то лучшее.

Я живо представил себе, как человек мог бы обдурить терминатора, который в поиске нового оптимального алгоритма действий бесцельно топчется на месте. С другой стороны грустно сознавать, что даже человеческая глупость может быть частью алгоритма.

Демис Хассабис заявил после матча, что разработчики AlphaGo вернутся в Великобританию и решат эту проблему. Также учтем, что у машины пока не подключена память. Мы, безусловно, вступаем в новую эру, наполненную машинами-детьми с точки зрения их поведения. Но при этом очень сильными интеллектуально. Есть старая история про греческого философа, который умер от смеха, наблюдая как пьяный осел ест инжир. Видимо, нас ждут подобные развлечения, когда мы будем смеяться над роботом, который мечется по квартире в поисках спрятанной от него грязной рубашки.

автор: Михаил Емельянов

Comments are closed.